本文转载自微信公众号“人机与认知实验室”(ID: 9h_9c3c1f805cb8),作者刘伟

DARPA的无人机大战有人机——“狗斗”测试刚刚结束,热闹过后,从测试后的回顾来看,AI获胜的关键在于极强的攻击性和射击的准确性,但问题主要在于判断存在失误。据美军测试人员的说法,测试中的AI系统经常在基本的战斗机机动中犯错误,AI不止一次地将飞机转向到其认为人类对手飞机会去的方向,但多次都被证明错判了人类飞行员的想法。这也不难理解,人类飞行员判断对手意图都经常出错,更何况AI系统缺的就是对创造性战术的理解能力,出现这类失误并不奇怪。然而,由于其"卓越的瞄准能力"和追踪对手飞机的能力,AI在整体上仍然能够保持对人类飞行员的优势,电脑系统最终在整个对抗中占据上风。

简而言之,无人机AI在“态”的精度和“感”的速度上占得先机,但在“势”的判断和“知”的预测上还不具备优势。建议以后的有人机飞行员多在假动作(就像乔丹、科比、詹姆斯那样)、打破规则(如同孙子、诸葛亮、粟裕一般)方面上狠下功夫吧!没有了规则,所有的算法和(数学)模型就会失去了边界、条件和约束,所有的计算就不再精确和可靠,当概率公式从算计变成了算命,机器的优势也许就不如人了吧?!

人是价值性决策——论大是大非而不仅仅是计算得失;机器是事实性决策——论得失加减,而不是是非曲直。

态、势之间与感、知之间的都是量和质的关系,其中的"势"即一定时期内的最大可能性。凡是在“势”中的,没有不是先已在“态”中的;凡是在“知”中的,没有不是先已在“感”中的。正可谓:星星之火可以燎原。如果目标明确,在与控制单元和装备组成的大系统博弈,对手应是或只能是相应的系统,不是操作装备的人,或者说是设计、操控系统的人。这方面,我们有很大的弱项。关键是开发环境下长中短期目标的动态变化会造成目标的不明确乃至模糊。

现在的人工智能就像高铁一样,速度很快,但是需要轨道,而真正的智能应该像飞机那样,只要能达到目的地,不需要特定的轨道和航线。态势感知的误差分为态、势、感、知方面的误差,也可分为事实性/价值性误差。人工智能在武器上的应用主要体现在机器对机器的任务布置和武器的实时重新瞄准上,这种对典型“服务提供者”的效果优先级排序将在战术层面执行,取决于智能化机器能否消化和分析来自整个战场的数据。事实上,人机功能分配中事实性与价值性的数据、信息、知识、责任、意向、情感混合/融合排序展开进行才是未来的有人-无人对抗之焦点和难点吧!

人最可怕的不是没有思想,而是满脑子标准答案;

机最可怕的是有“思想”,而且能够做到“先输后赢”;

人机混合最怕的是被误认为是人工智能。

偶感一则

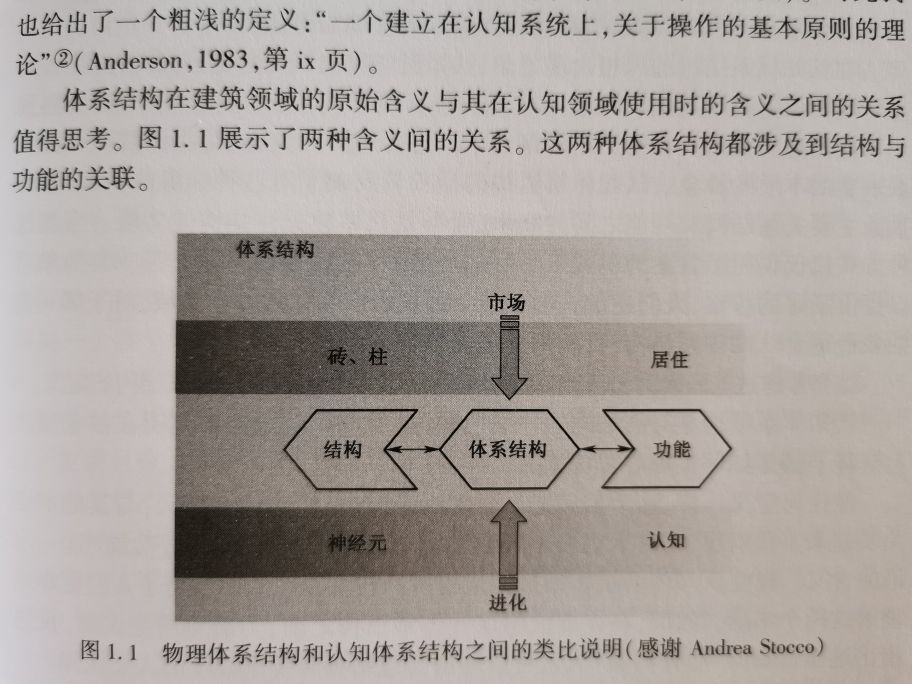

上页中图1.1(一些认知模型的基础)中建筑结构与计算机结构的类比可能是错误的,错在何处呢?!

ACT—R模型的提出者安德森(Anderson)认为,认知体系结构是对脑结构的详细说明,这种说明在抽象层次上解释了脑是如何实现心智功能的。

安德森(Anderson)的这个观点应该也是错误的,真正的认知体系结构不是对脑结构的详细说明,这种说明在抽象层次上也不能解释脑是如何实现心智功能的。

正确的观点应该是:认知体系结构是对人机环境系统交互过程—这个动态结构的详细说明,这种说明在抽象层次上解释了人是如何实现心智功能的(脑仅是人的一部分,人类还有其它部分,如腹脑)。

上图错在:左边的结构上面是砖、柱,下面是神经元;

实际上,左边的结构上面是砖、柱,下面是人+物+环境;神经元和脑都是人的局部。

所以:

安德森(Anderson)提出的ACT—R模型可能先天不足:认知体系结构失调。